导读:为了便于“GPT+数字孪生战场”微信群成员了解本周六咖啡时间的主题,转载李刚等人撰写的《多源卫星数据在轨智能融合技术》一文,加上群里面分享的多份报告和PPT,构成进一步交流讨论的基础。

多源卫星数据融合能够综合利用多时相、多角度、多谱段、主被动等感知手段,提升遥感信息获取的准确性和稳健性。传统的多源卫星数据融合采用“卫星采集数据下传+地面融合处理”的工作方式, 信息感知以及后续决策制定的时效性低。

近年来,我国航天事业蓬勃发展,遥感卫星数量不断增多,载荷类型不断丰富,空间信息网络通信能力不断提升,在轨数据处理能力不断加强。发展多源卫星数据在轨智能融合技术恰逢其时,这对提升我国全球范围快速感知响应能力具有重要意义。

本文分析了发展多源卫星数据在轨智能融合技术的战略意义,总结了该领域国内外发展现状,分析了关键科学技术问题,并提出了未来发展建议。

1 多源卫星数据在轨智能融合的战略意义

多源卫星数据融合是提升遥感信息获取准确性和稳健性的有效手段。多源卫星数据是通过多时相、多角度、多谱段、主被动等方式获取的多个星载传感器数据,这些传感器可以搭载在同一个卫星平台上,也可以分别搭载在多个卫星平台上。多源数据融合能够实现信息的有效互补,消除数据间的冲突与不确定性,获取比单一数据源更为准确可靠的信息[1]。

传统的多源卫星数据融合采用“卫星采集数据下传+地面融合处理”的工作方式。各个卫星传感器在轨采集数据、并通过星地链路把数据传回地面,地面融合中心对全部多源卫星数据进行集中融合处理,充分利用地面丰富的存储与计算资源,并辅以专家知识和人工判读,能够获得最优的融合处理信息准确性和稳健性。然而,这种工作方式的缺点是时效性低。导致这一缺点的原因主要包括以下两点:(1)我国境外地面站建设的限制。卫星采集的数据只有在经过我国国境和境外少数地面站时才能下传,收集齐所需多源卫星数据需要几小时甚至更长时间,导致了事件发生时刻和数据传输时刻之间的延迟。(2)星地链路数传速率的限制。随着探测区域的扩大和传感器分辨率的提升,星上数据采集速率已经达到十几甚至几十Gbps,而多数星地链路数传速率仅为几百Mbps到Gbps,而且前者的增速快于后者的增速,导致了星上数据传输时刻和地面接收数据齐备时刻之间的延迟。因此,传统的“卫星采集数据下传+地面融合处理”工作方式难以满足时敏目标检测识别、应急救援、灾害评估、热点区域持续监视等高时效性任务的需求。

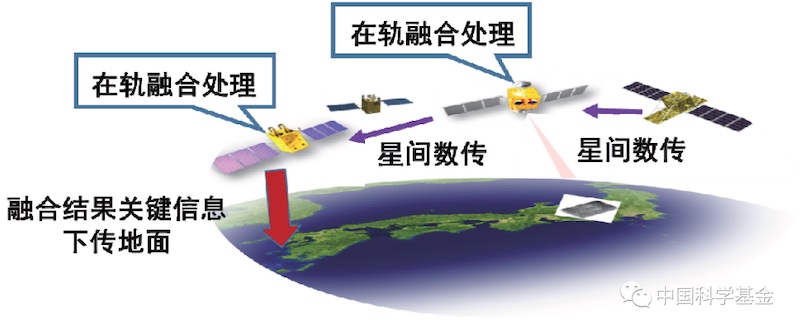

我国国家利益拓展对全球范围快速感知响应能力提出了很高的要求。例如:对南海、东海的重要舰船检测识别的感知响应需求达到分钟级,对灾害监测评估和全球热点事件区域监视的感知响应需求达到十分钟级。为了满足不断提升的快速感知信息的需求,迫切需要多源卫星数据在轨智能融合技术。多源卫星数据在轨融合的示意图如图1所示,卫星不再向地面传输高维的原始数据,通过卫星数据各自在轨处理、多源卫星数据的在轨交互与融合处理,在星上获取目标有无、目标数量、目标类别、编队构型、事件变化、灾害范围和等级等关键信息,把蕴含关键信息的低维数据通过星间链路、星地链路快速传递给用户,从而在遥感卫星可达、星间数据可传的条件下,在全球范围内实现“关键信息即时可知”。

图1 多源卫星数据在轨融合示意图

综上所述,发展多源卫星数据在轨智能融合技术对提升我国全球范围快速感知响应能力具有重要的战略意义。

2 多源卫星数据在轨智能融合技术的发展现状

多源卫星数据在轨智能融合技术的发展和以下几个因素密切相关。

(1) 卫星平台的发展

从载荷角度来看,卫星平台正在从单载荷模式走向多载荷模式。任何单一传感器载荷都存在其优势和局限。例如:光学遥感卫星图像信息丰富,但容易受光照条件和云雾雨雪等自然因素影响;合成孔径雷达(SAR)遥感卫星能全天时全天候工作,但图像解译难度较大;电子侦察卫星能够监听宽频谱范围的无线电信号,但容易受电磁欺骗和干扰影响…因此,通过在单颗卫星上搭载多种不同类型的传感器载荷,有助于实现功能互补、感知能力提升。日本于2006年发射的ALOS卫星有三个传感器载荷:一是全色遥感立体测绘仪,主要用于数字高程测绘;二是先进可见光与近红外辐射计, 用于精确陆地观测;三是相控阵型L波段合成孔径雷达,用于全天时、全天候陆地观测[2]。美国于2013年发射的Landsat 8卫星有两个传感器载荷:一是陆地成像仪,用于地表覆盖分类、云检测等;二是热红外传感器,用于感知热辐射目标和地表水分消耗等[3]。我国于2019年发射的高分七号卫星有两个传感器载荷,分别是双线阵立体相机和激光测高仪,二者融合实现了对地立体测绘[4]。

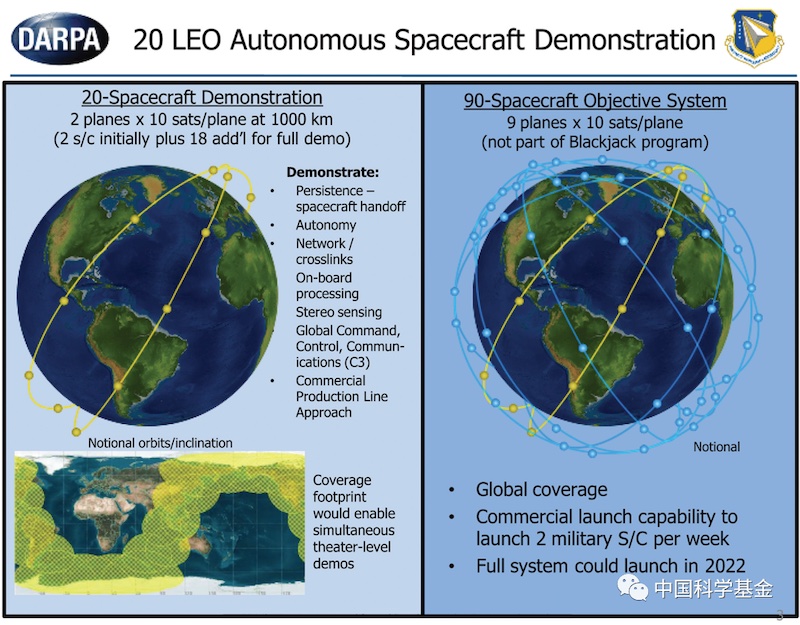

从系统角度来看,卫星平台正在从单星独立工作模式走向多星组网协同工作模式。高轨、中轨、低轨多颗卫星通过星间链路传输数据、信息、指令,形成协同工作的卫星网络,实现对感兴趣的区域和目标的持续或接力观测,并获取多时相、多角度、多谱段、主被动等多类型感知数据。美国国防高级研究计划局(Defense Advanced Research Projects Agency, DARPA)正在实施的Blackjack小卫星星座装配多种类型传感器载荷,具备在轨处理数据、星间数据共享、多星协同工作、去中心化自主决策等能力,可实现卫星有效载荷的高度网络化和弹性化,以达到在全球范围内为军方用户提供高时效性感知信息的目的[5]。Blackjack任务功能示意图如图2 所示。我国国家自然科学基金委在2013年设立了空间信息网络基础理论与关键技术重大研究计划,科技部在十三五期间设立了天地一体化信息网络重大工程项目,这些重大项目攻关为多星组网协同积累了必要的理论、方法和技术。武汉大学李德仁院士提出了定位、导航、授时、遥感、通信(Positioning, Navigation, Timing, Remote Sensing, Communications, PNTRC)一体的天基信息服务系统建设构想,这代表了未来卫星系统发展的趋势。

图2 美国DARPA-Blackjack任务功能示意图

(2) 信号处理算法和硬件算力的发展

从信号处理算法输入的角度分类,多源卫星数据融合算法可大致分为数据层融合算法、特征层融合算法和决策层融合算法[6]。

数据层融合算法的输入是多源卫星原始数据或原始图像,融合处理带来的信息损失较小。此类算法需要对多源卫星数据进行严格配准,对星上计算能力、星间数传能力有很高的要求,且对多源卫星数据模态的一致性要求较高。

特征层融合算法的输入是多源卫星数据各自处理得到的一些关键特征参数矢量。此类算法以一定的信息损失为代价,针对检测、分类等用户指定的任务,对从各数据中提取出的有价值低维度特征信息进行融合,不依赖多源卫星原始数据或原始图像的精细配准,具备一定的异构数据融合处理能力。相比数据层融合算法,特征层融合算法显著降低了对星上计算能力、星间数传能力的要求。

决策层融合算法的输入是多源卫星数据各自处理得到的决策结果。相比前两类算法,此类算法进一步降低了对星上计算能力、星间数传能力的要求,能够更好地适应多源异构卫星数据。为此所付出的代价是,此类算法带来的信息损失更大。

由于多源卫星数据在轨融合的必要性主要体现在满足高时效性任务应用需求,因此保证星上处理实时性尤为重要。从这个角度考虑,如果特征层融合算法和决策层融合算法能够满足应用需求,则这两类算法可作为多源卫星数据在轨融合处理的首选;如果必须使用数据层融合算法才能满足应用需求,则对星上计算和存储资源提出了更高要求。

从信号处理算法设计原理来看,主成分分析、小波变换、稀疏信号处理、贝叶斯决策、证据推理、模糊分类、神经网络等相关理论和算法都被应用于多源卫星数据融合。近年来,以深度卷积神经网络(Deep Convolutional Neural Network, DCNN)为代表的人工智能算法在多源卫星数据融合领域的应用受到了广泛关注,公开文献中的多组实际数据处理结果表明,DCNN等人工智能算法能够有效提升多源卫星数据融合处理的性能。然而,为了实现基于DCNN的多源卫星数据在轨融合计算,需要对DCNN进行简化。可选用的DCNN简化手段包括轻量化网络和知识蒸馏等。轻量化网络的核心在于设计简洁的网络数据流向以取代传统的卷积核,达到简化网络的目的。例如,SqueezeNet所提出的squeeze操作和expand操作相结合的fire层和MobileNet的深度可分离卷积层(Deep-wise Separable Convolutional),可以大幅度降低网络参数规模并提升算法计算效率[7,8]。知识蒸馏的基本思想是网络模型压缩,通过教师—学生(Teacher-Student)模式,让已训练好的复杂网络模型(Teacher)和目标简单网络模型(Student)的输出分布充分接近[9]。这些方法已经在移动用户端得到应用,这为多源卫星数据在轨融合的算法设计提供了有益的参考。

在多源卫星数据融合算法设计方面,国内近年涌现出很多优秀成果。中国科学院空天信息创新研究院、中国科学院自动化研究所、武汉大学、湖南大学、北京航空航天大学、北京理工大学、西安电子科技大学、西北工业大学、北京师范大学、首都师范大学、中国人民解放军国防科技大学、中国人民解放军海军航空大学、清华大学等单位分别提出了一系列先进的多源卫星数据融合算法,部分算法的处理性能达到了国际先进水平。

在多源卫星数据在轨融合算法得到不断发展的同时,星上处理硬件算力也在不断提升。常用的星上处理器包括数字信号处理器(Digital Signal Processor,DSP)、现场可编程门阵列(Field Programmable Gate Array,FPGA)、中央处理器(Central Processing Unit,CPU)、以及专用片上系统(System on Chip,SoC)等。限于篇幅,这里仅以FGPA为例,介绍星上处理硬件算力的最新发展水平。赛灵思(Xilinx)在2020年推出了业界第一款20 nm太空级FPGA芯片XQRKU060[10],在各太空轨道具有优秀的辐射耐受能力,可在轨重配置。和Xilinx以前推出的65 nm太空级FPGA芯片相比,这款新芯片的尺寸、重量和功率都得到显著降低,同时其数字信号处理性能呈数量级提升,能够支持高性能机器学习算法的运行。信号处理算法与硬件算力的紧密耦合与迭代进步,为多源卫星数据在轨融合处理的可行性提供了充分支撑。

综上所述,随着卫星平台、载荷、星间通信、信号处理算法、硬件算力等领域的飞速发展,突破多源卫星数据在轨智能融合技术的基础条件已经基本成熟。

3 多源卫星数据在轨智能融合的关键科学技术问题

要实现多源卫星数据在轨智能融合,需解决以下关键科学技术问题。

(1)卫星资源约束条件下的多源异构数据融合理论。卫星系统的固有参数,如:卫星重访时间、星间数传能力、多源异构数据特性与分辨率差异等,是多源卫星数据在轨智能融合的约束条件。在这些约束条件下,如何定量化描述多源卫星数据的相关性并给出融合处理性能的极限分析,需要在多源异构数据融合理论上做出创新。

(2)在轨任务自主规划方法。在卫星资源约束条件下,按照多源异构数据融合理论的指导,针对若干高时效性任务(如:时敏目标检测识别、应急救援、灾害评估、热点区域持续监视等),提出在轨任务自主规划方法,与地面指令上注相结合,依托软件定义系统结构,在轨实现多颗卫星载荷、计算、数传等资源智能调度与协同使用。

(3)结合专家知识的多源卫星数据在轨智能融合处理算法。在地面实现多源卫星数据融合处理时,人工参与和专家知识对调整算法、提升处理性能起到了重要作用。然而,在轨处理是完全自动化的,难以实时引入专家知识。因此,需要把专家知识表征为数学模型,嵌入星上融合智能算法设计中。

(4) 轻小型低功耗在轨融合计算方案。卫星对未来在轨数据处理系统的体积、重量、功耗有更为严苛的要求。因此,应充分应用计算器件、存储器件、系统结构等领域的最新研究成果,突破混合计算架构、字长自动设计等技术,发展轻小型、低功耗的多源卫星数据在轨智能融合处理系统。

4 促进多源卫星数据在轨智能融合技术的建议

为提升全球范围快速感知响应能力,促进多源卫星数据在轨智能融合技术的发展,提出以下建议:

(1)梳理需求,明确方向。以用户需求为导向,按照需求的重要性和紧急性排序,梳理迫切需要多源卫星数据在轨智能融合处理的若干高时效性应用需求。在未来较短时期内,加速发展以满足这些需求为目标的多源卫星数据在轨智能融合专用系统。

(2)进一步丰富卫星数据库。在国内外已经公开的卫星数据库基础上,进一步丰富、共享卫星数据,解决各部门“数据孤岛”问题。有意识地加强对观测相同区域、相同目标的多源异构卫星数据的增补和标注,重视对重点区域长时间观测的多源异构卫星数据积累。

(3)开展解决方案的竞赛。依托统一的多源卫星数据集,瞄准若干需求,针对软硬件相结合的解决方案开展竞赛。吸引算法、器件、系统等多学科领域的学者和工程师组队参赛,从性能、价格、体积、重量、功耗等多个角度综合评估解决方案,缩短研发样机和实际星上设备之间的距离。

作者:李刚、刘瑜、张庆君

参 考 文 献

[1]何友, 王国宏, 关欣. 信息融合理论及应用. 北京: 电子工业出版社, 2010.

[2]中国遥感数据网. ALOS卫星. [2021-02-10]. http://rs.ceode.ac.cn/satelliteintroduce/introALOS.jsp#ALOS.

[3]中国遥感数据网. Landsat卫星. [2021-02-10]. http://rs.ceode.ac.cn/satelliteintroduce/introLandsats.jsp#Landsat-8.

[4]自然资源卫星遥感云服务平台. 高分七号卫星. [2021-02-10]. http://www.sasclouds.com/chinese/satellite/chinese/gf7.

[5]Thomas P. DARPA Blackjack demo program-pivot to LEO and tactical space architecture. Arlington: DARPA Tactical Technology Office, 2018.

[6]孙洪泉, 窦闻, 易文斌. 遥感图像融合的研究现状、困境及发展趋势探讨. 遥感信息, 2011, 26(1): 104—108.

[7]Iandola FN, Han S, Moskewicz MW, et al. SqueezeNet: alexNet-level accuracy with 50x fewer parameters and <0.5MB model size. International Conference on Learning Representations. 2017: 1—14.

[8]Howard A, Zhu M, Chen B, et al. MobileNets: efficient convolutional neural networks for mobile vision applications. IEEE Conference on Computer Vision and Pattern Recognition, 2017: 1—9.

[9]Ge S, Zhao S, Li C, et al. Low-resolution face recognition in the wild via selective knowledge distillation. IEEE Transactions on Image Processing. 2019, 28: 2051—2062.

[10]XILINX. RT Kintex UltraScale FPGAs for ultra high throughput and high bandwidth applications. (2020-05-19)/[2021-04-22].

https://www.xilinx.com/support/documentation/white_papers/wp523-xqrku060.pdf.

评论