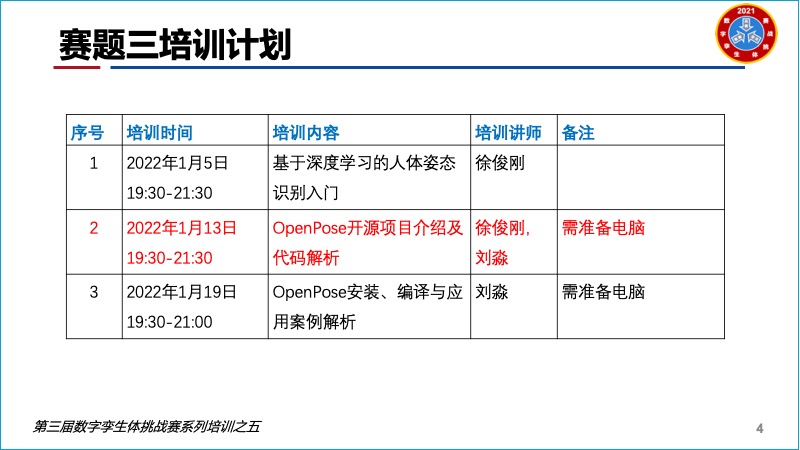

2022年1月13日,中科院大学计算机学院教授徐俊刚和博士生刘淼共同分享了《OpenPose开源项目介绍及代码解析》在线直播,这是第三届数字孪生体挑战赛系列之五,针对参与第3赛题的团队学习了解OpenPose开源项目需要。

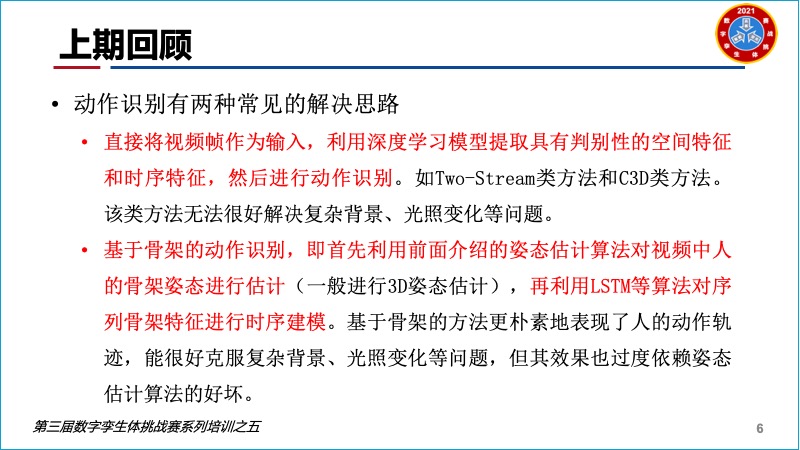

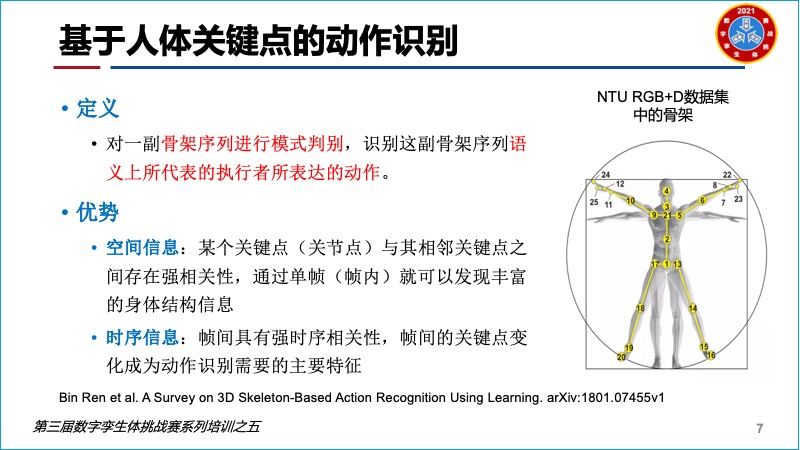

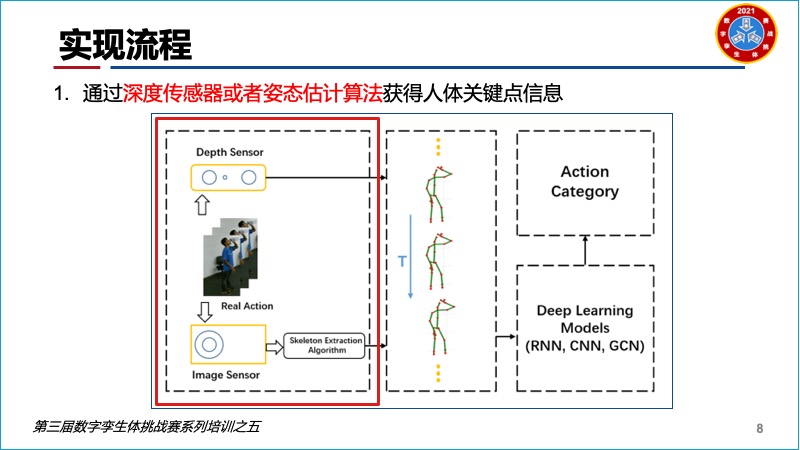

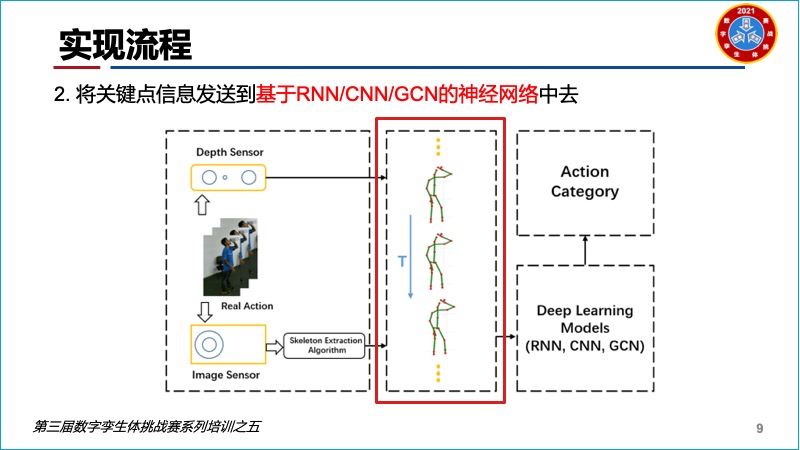

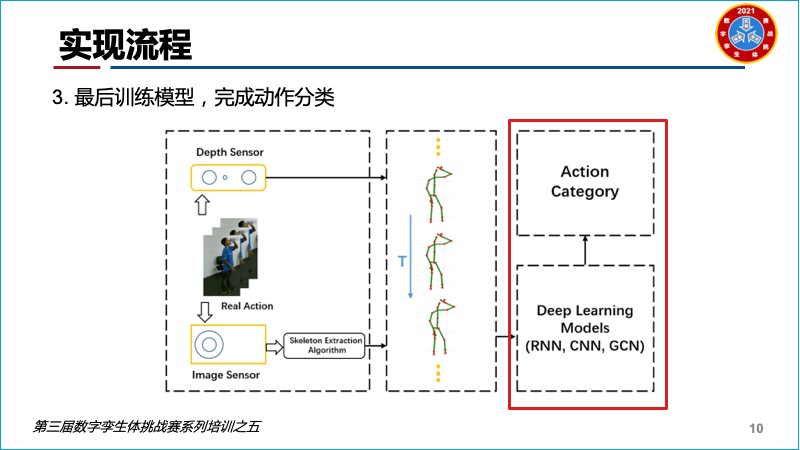

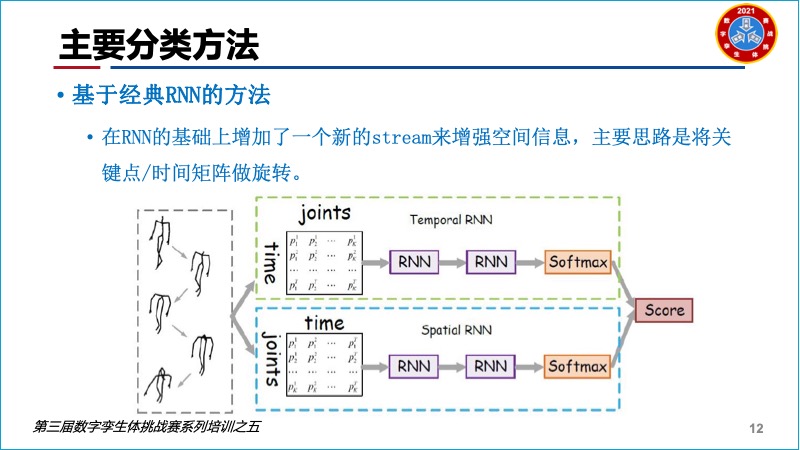

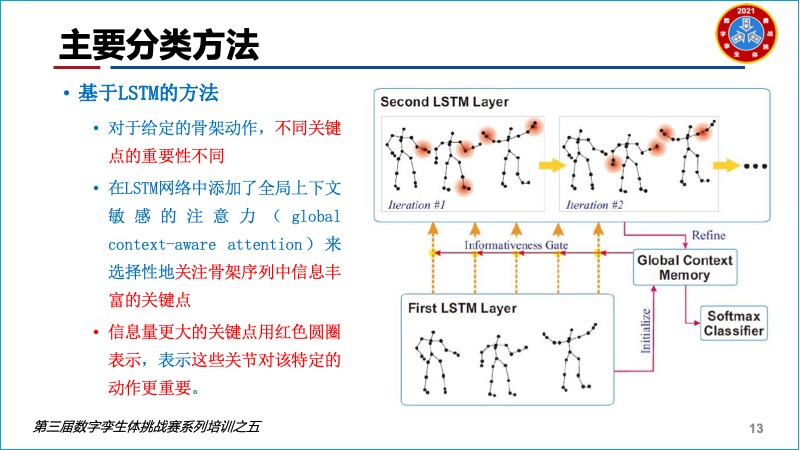

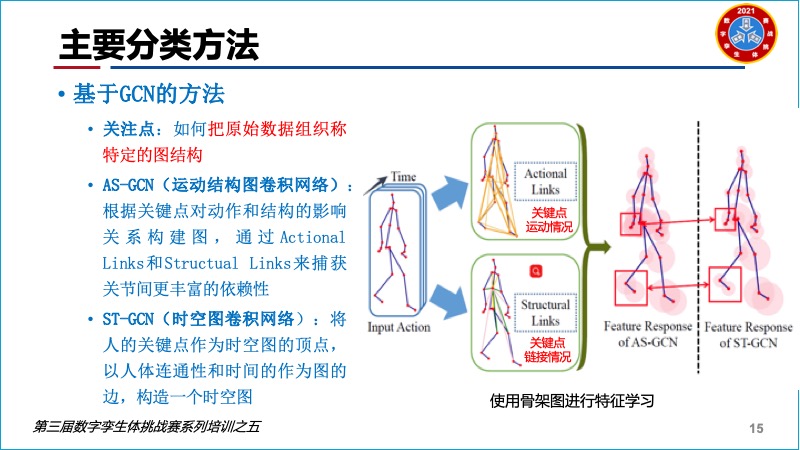

徐教授首先回顾了上次讲解的两种动作识别方法,即:直接将视频帧作为输入,利用深度学习模型提取具有判别性的空间特征和时序特征,然后进行动作识别;利用前面介绍的姿态估计算法对视频中人的骨架姿态进行估计,再利用LSTM等算法对序列骨架特征进行时序建模。

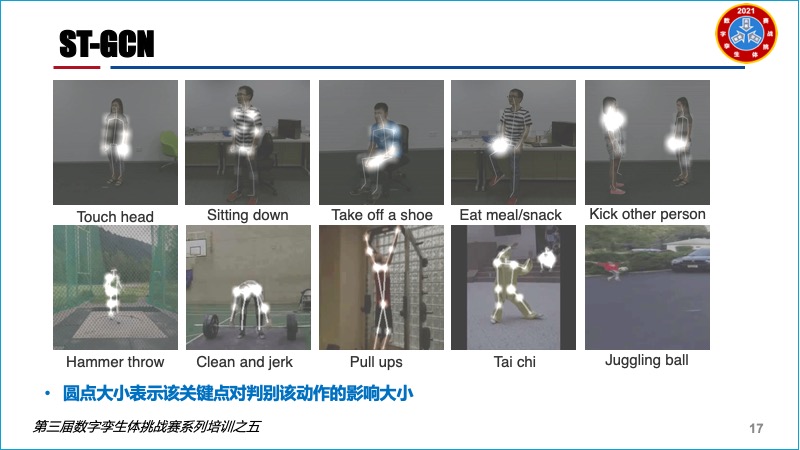

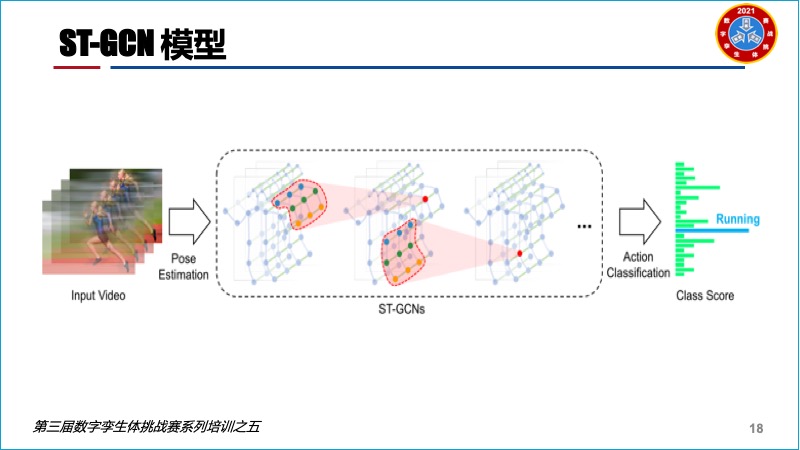

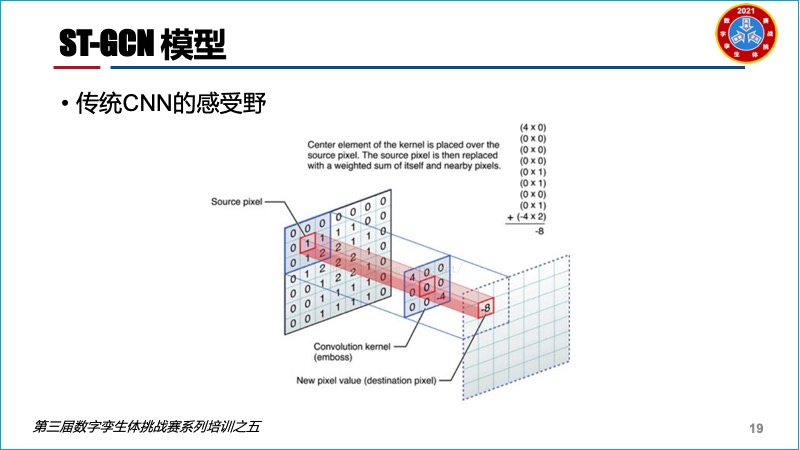

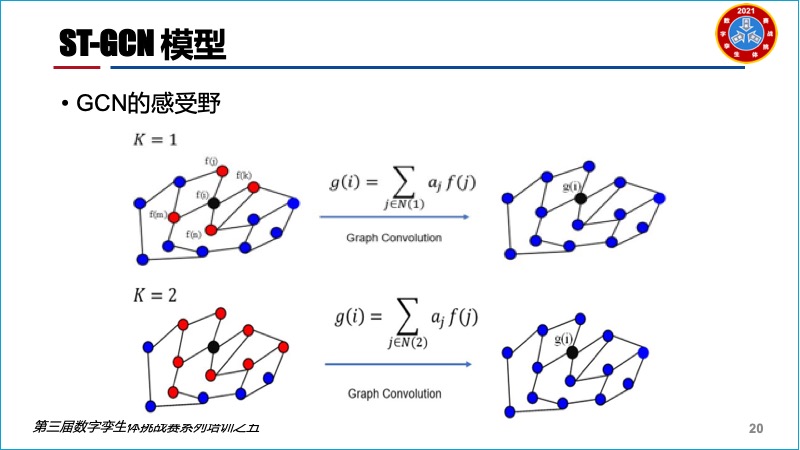

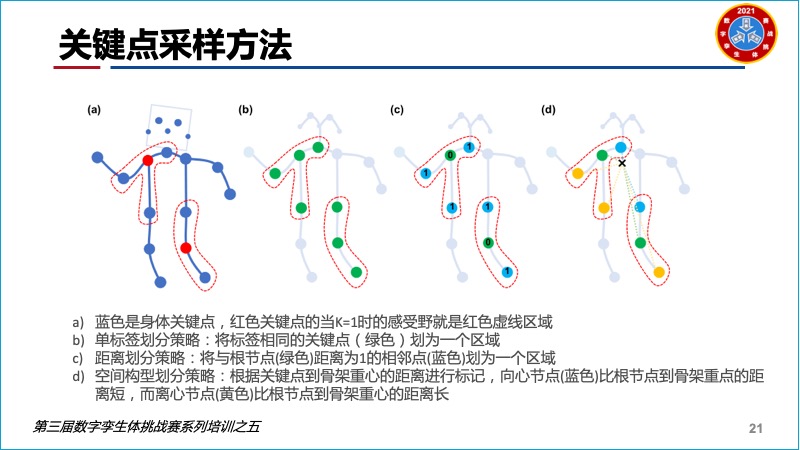

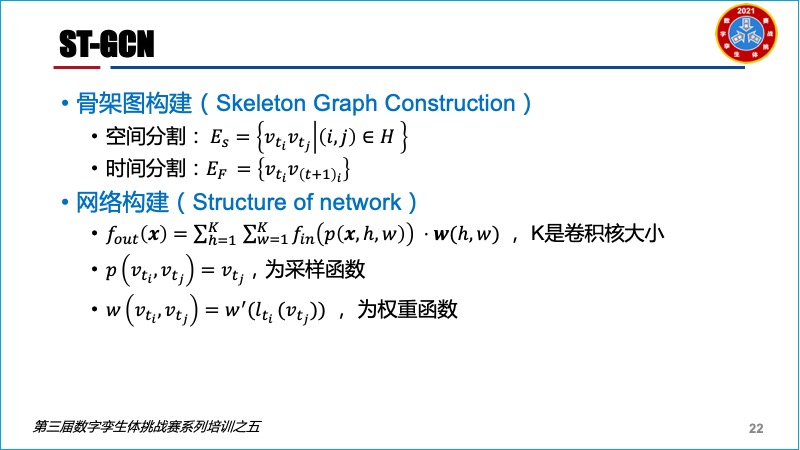

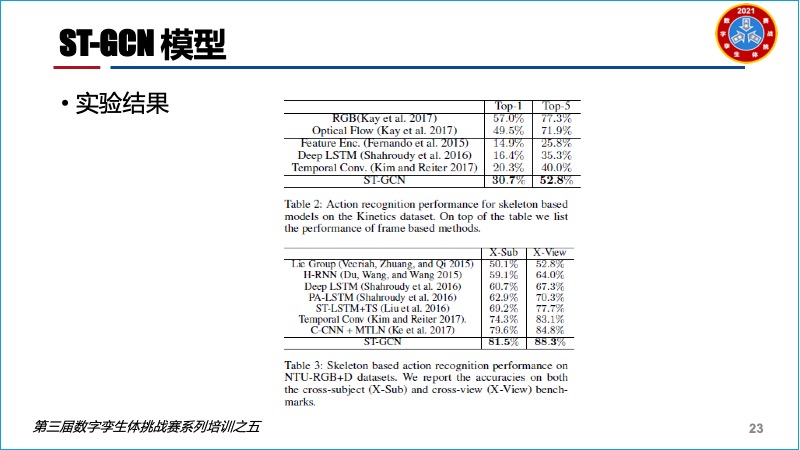

然后进一步介绍了ST-GCN(时空图卷积网络),即将人的关键点作为时空图的顶点,以人体连通性和时间的作为图的边,构造一个时空图。

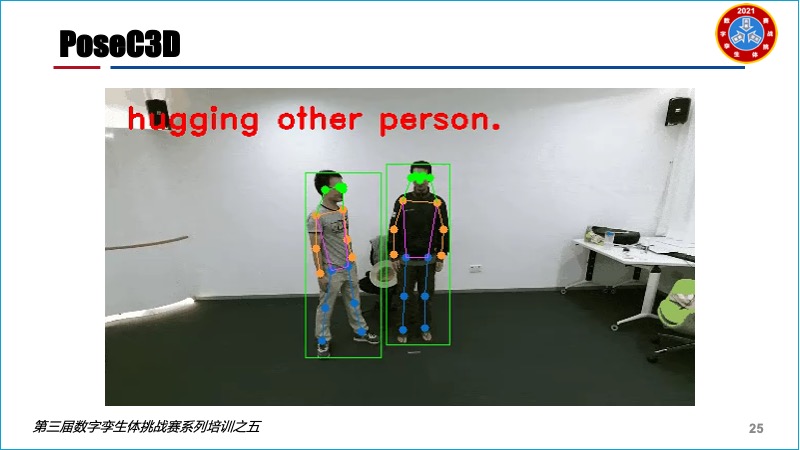

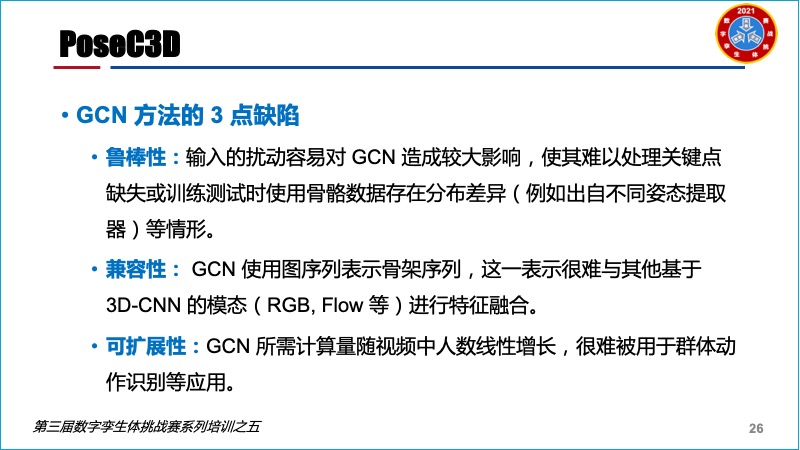

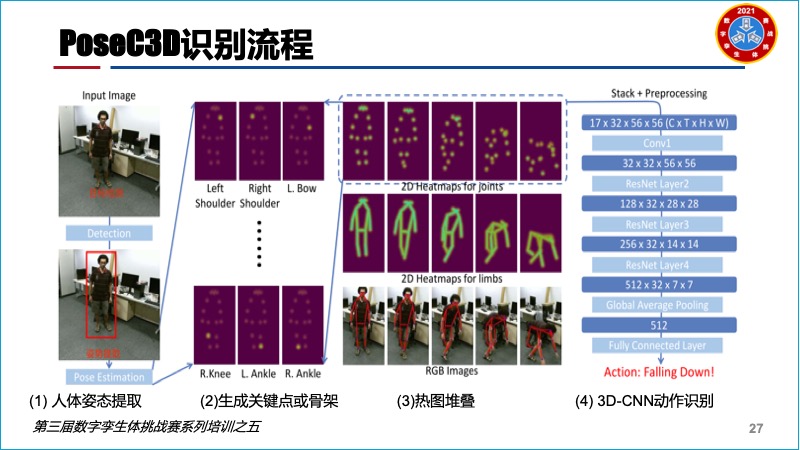

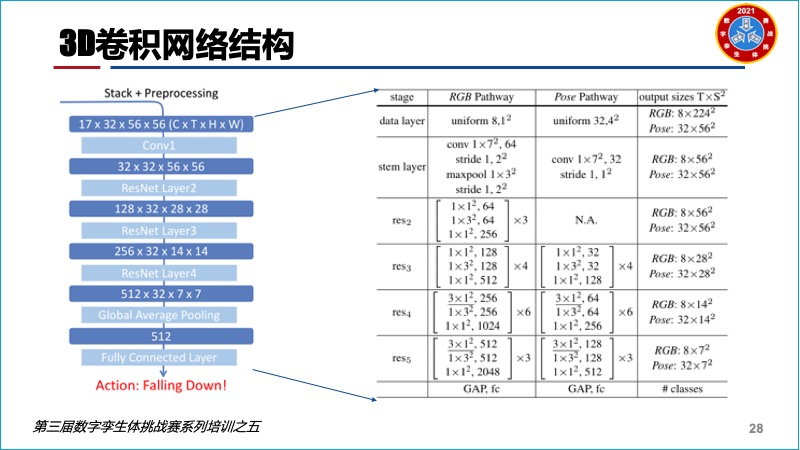

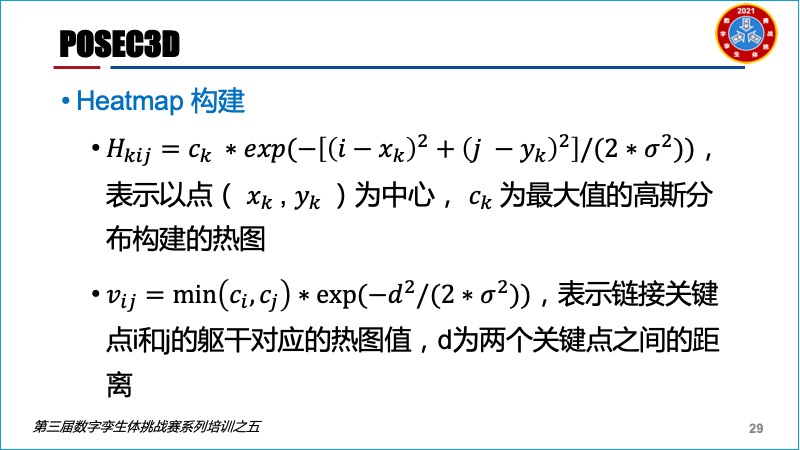

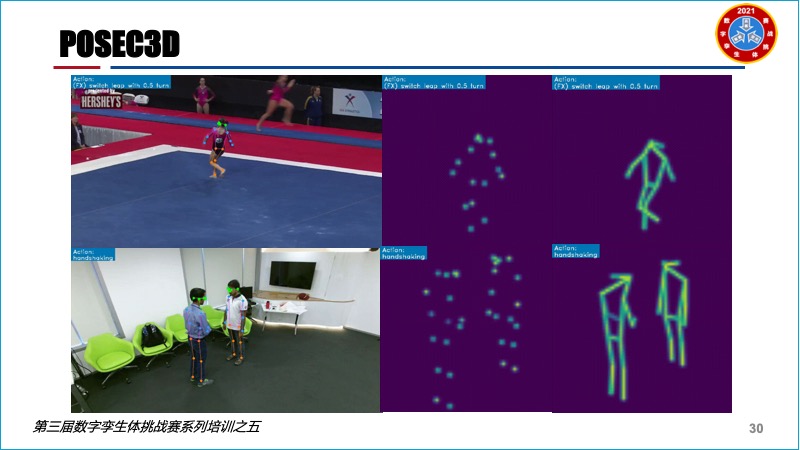

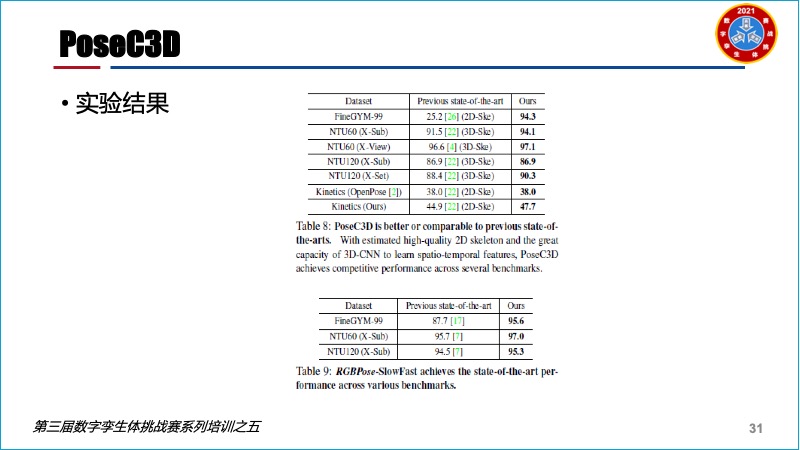

而且还对PoseC3D识别方法做了图文并茂的分析,这是一种基于 3D-CNN 的骨骼行为识别框架,同时具备良好的识别精度与效率,在包含 FineGYM, NTURGB+D, Kinetics-skeleton 等多个骨骼行为数据集上达到了业内较好水平。

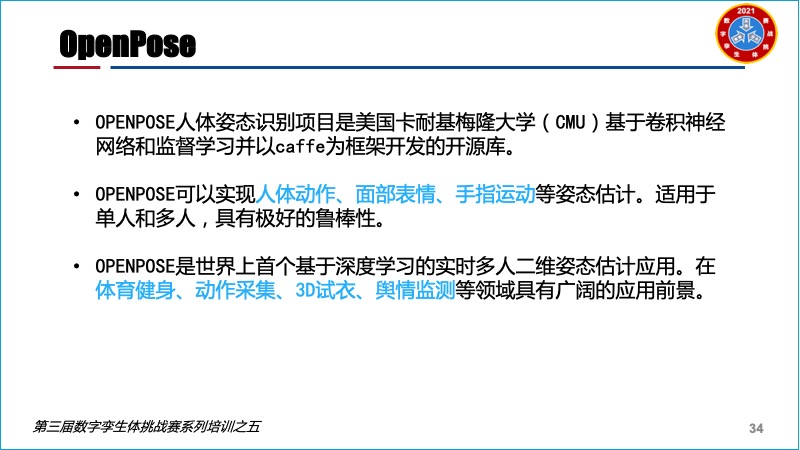

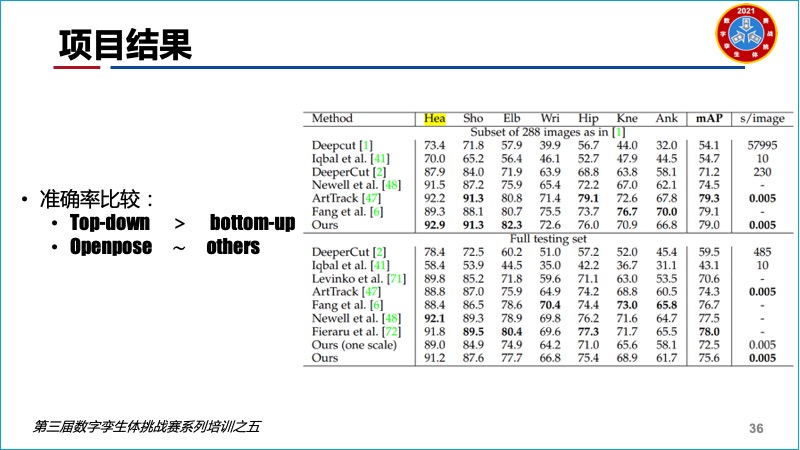

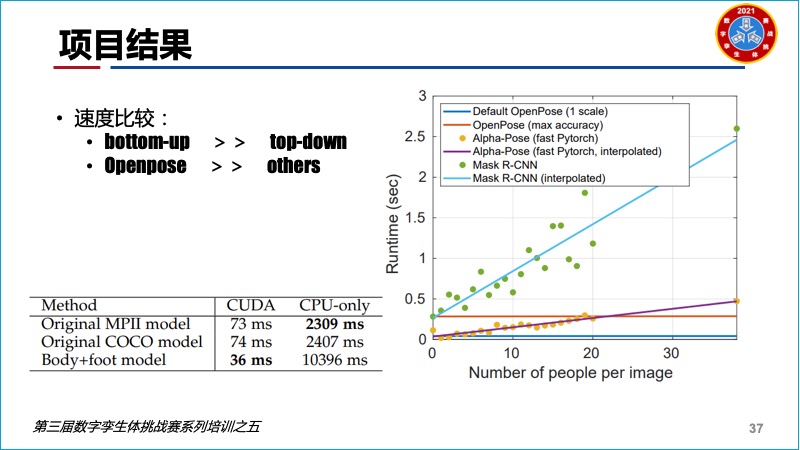

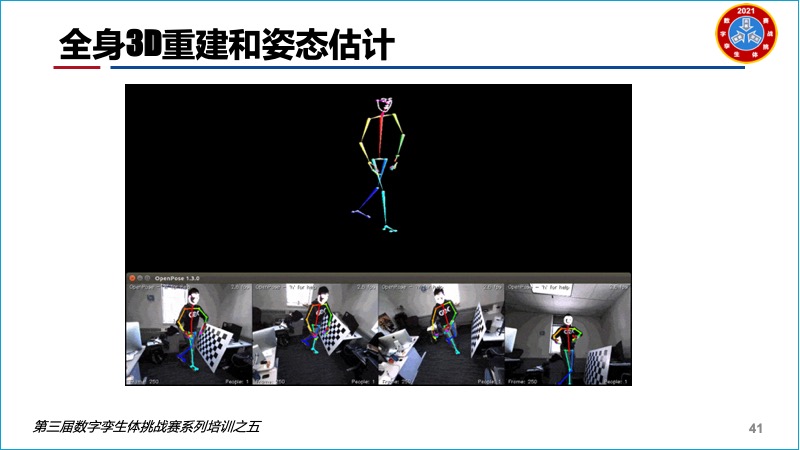

接着刘淼对OpenPose的来龙去脉做了介绍,由于它的实时性较好,对单人和多人识别效果都不错,能够实现人体动作、面部表情、手指运动等姿态估计,在体育健身、动作采集、3D试衣、舆情监测等领域具有广阔的应用前景。

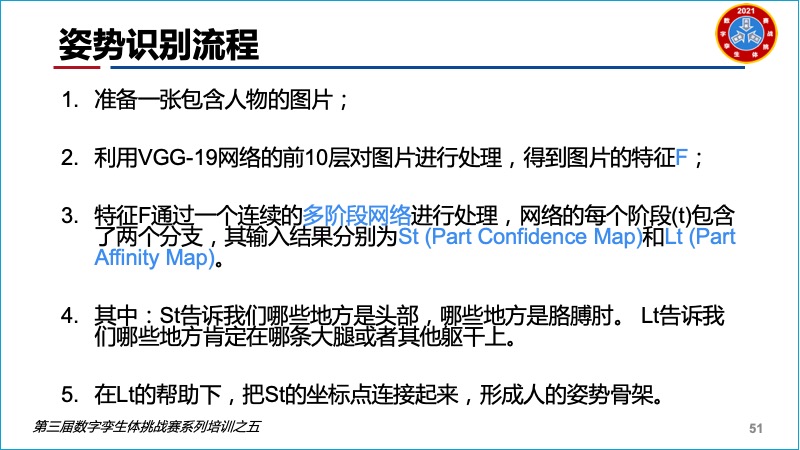

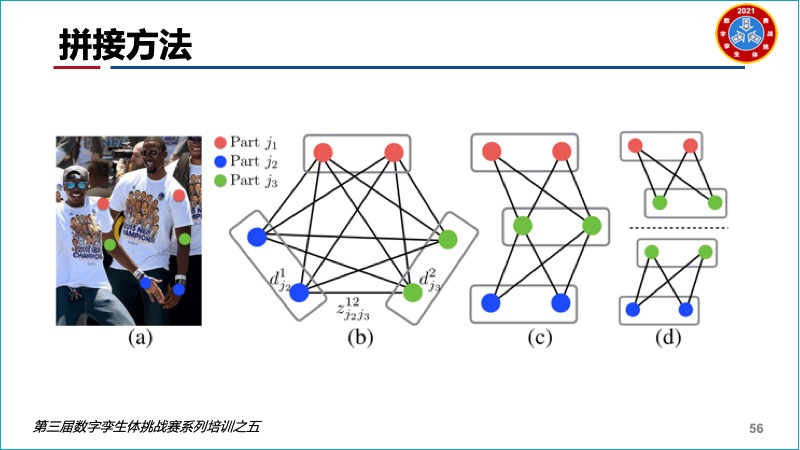

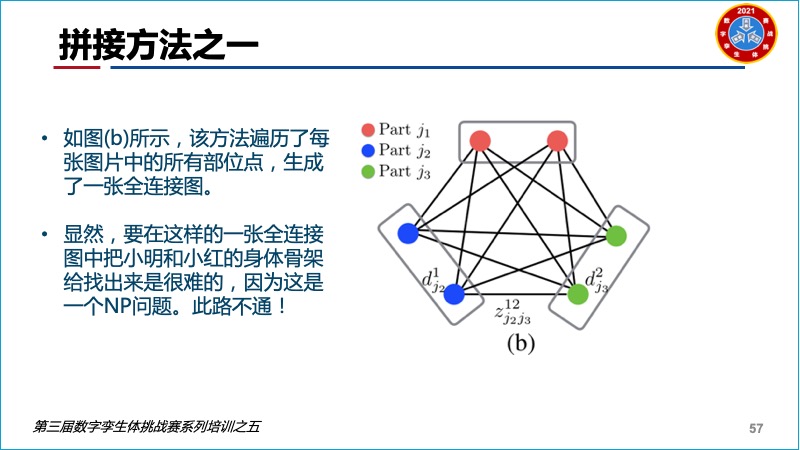

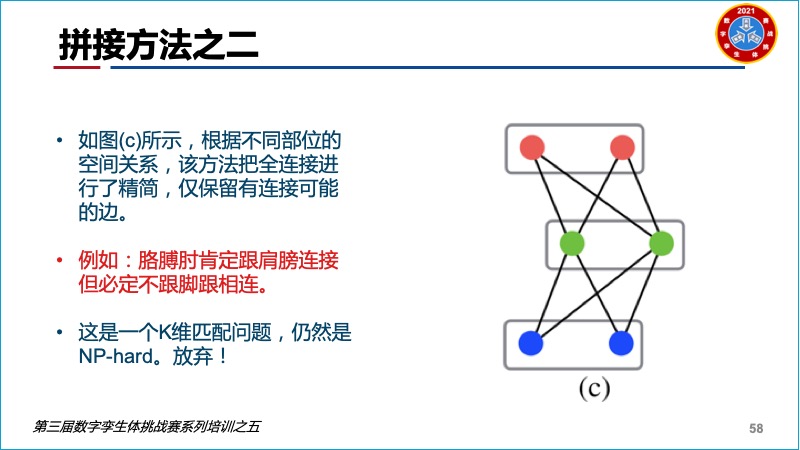

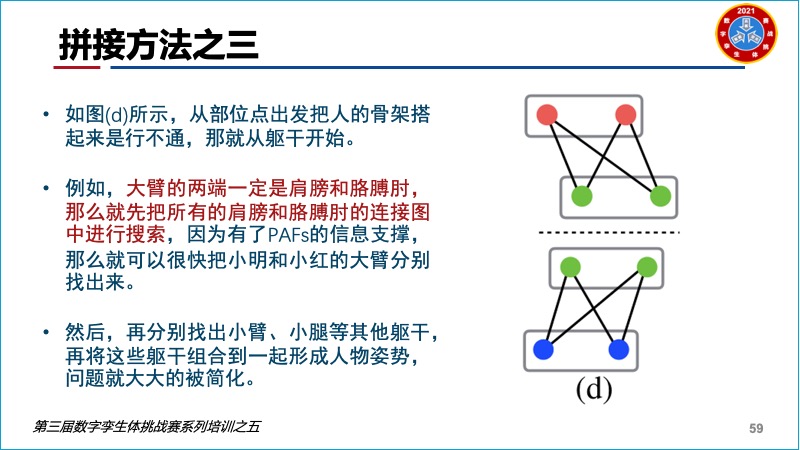

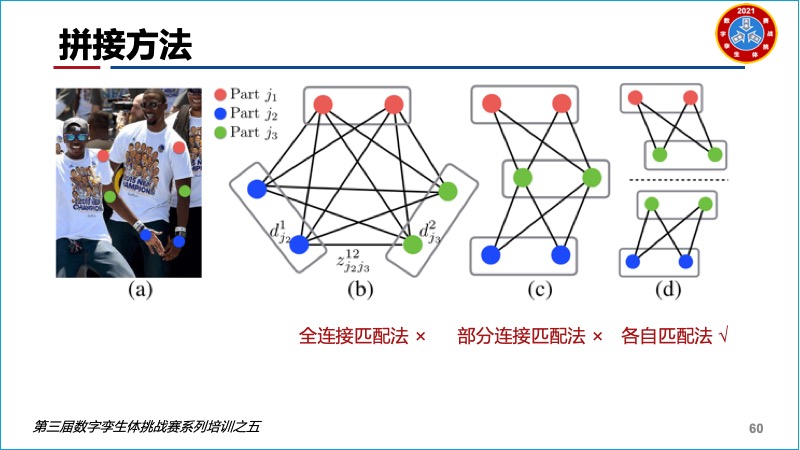

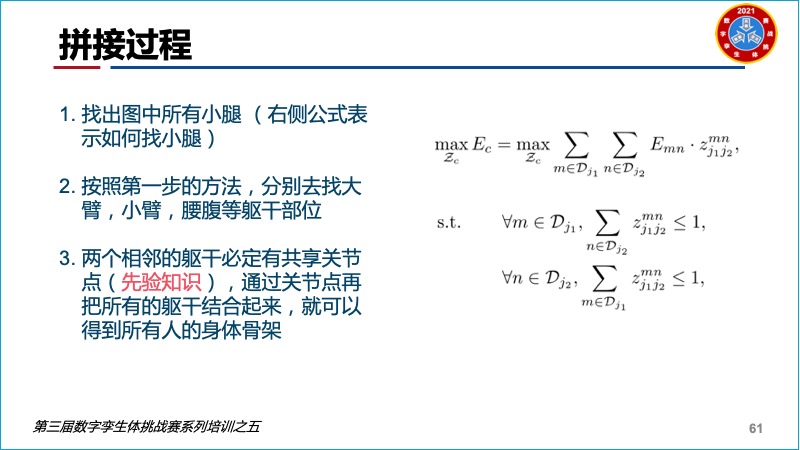

对于利用OpenPose进行姿态识别:

1.准备一张包含人物的图片。

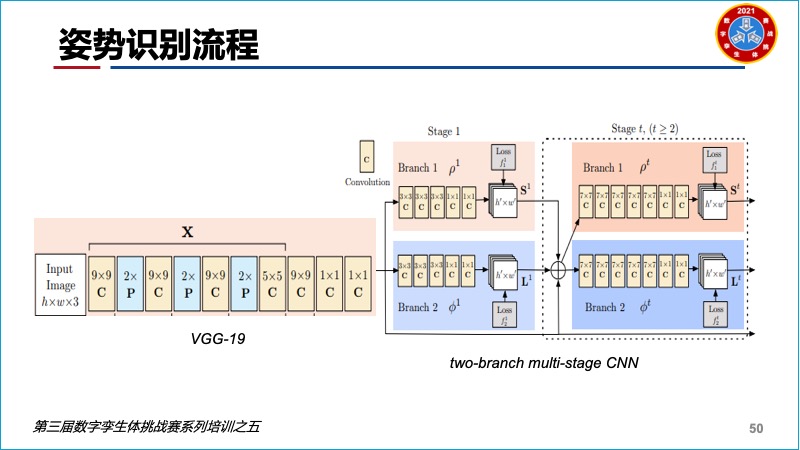

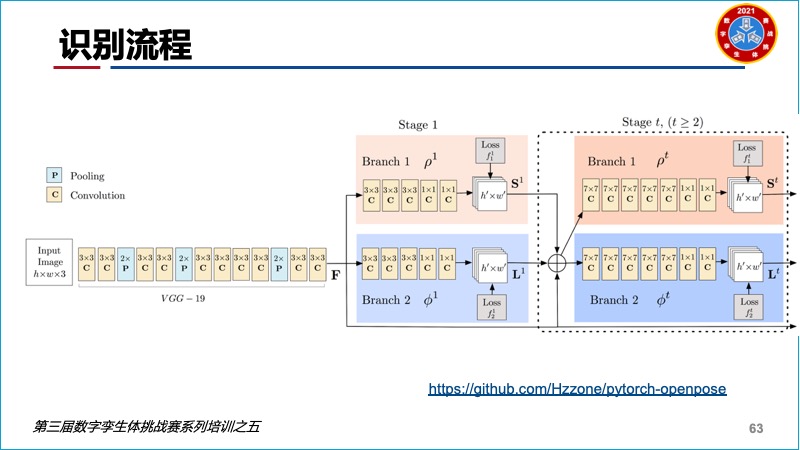

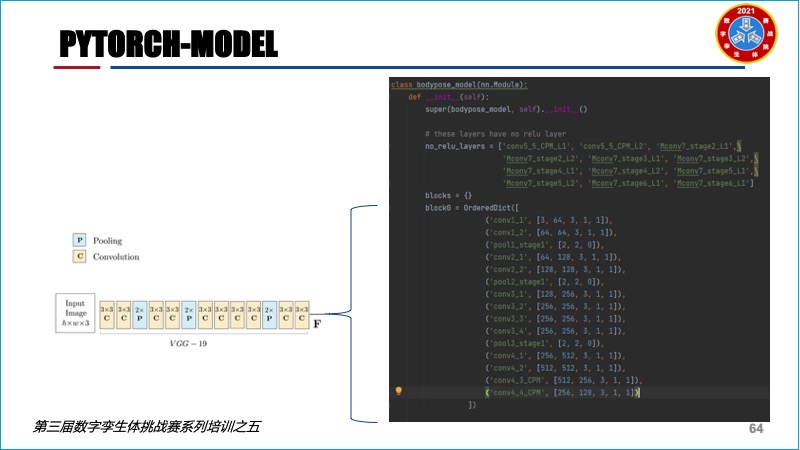

2.利用VGG-19网络的前10层对图片进行处理,得到图片的特征F。

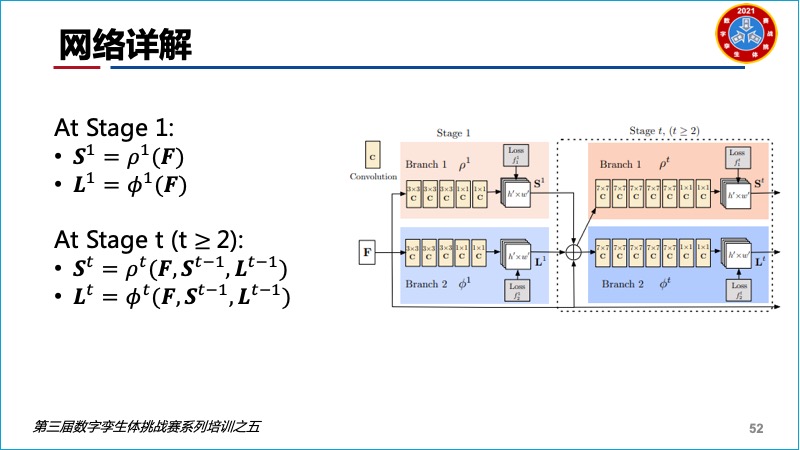

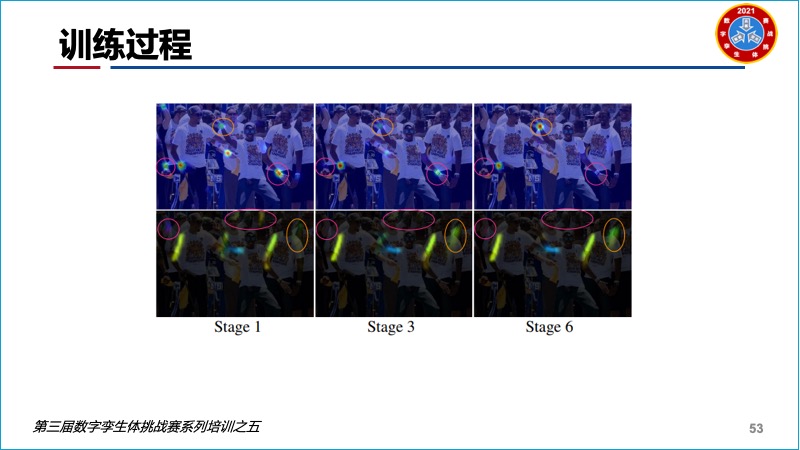

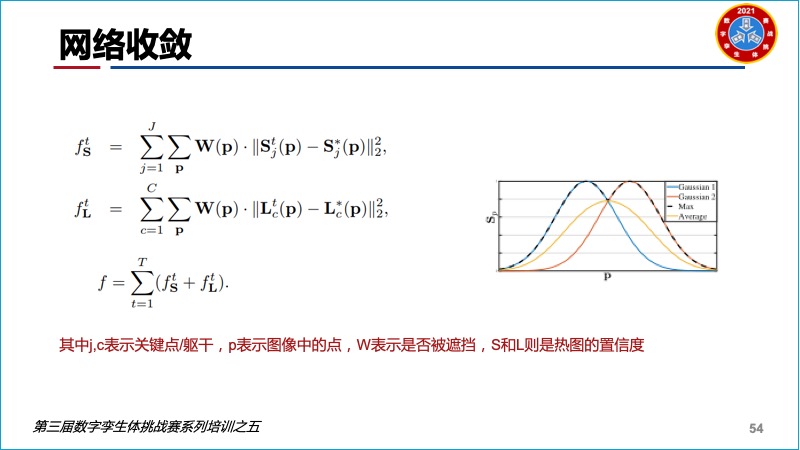

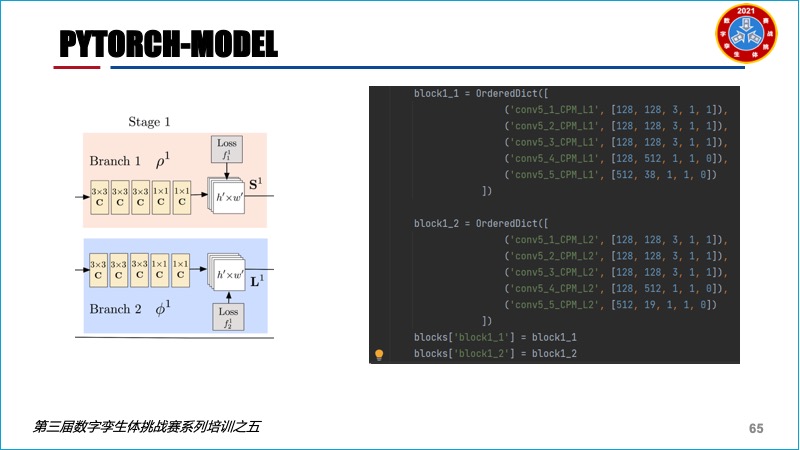

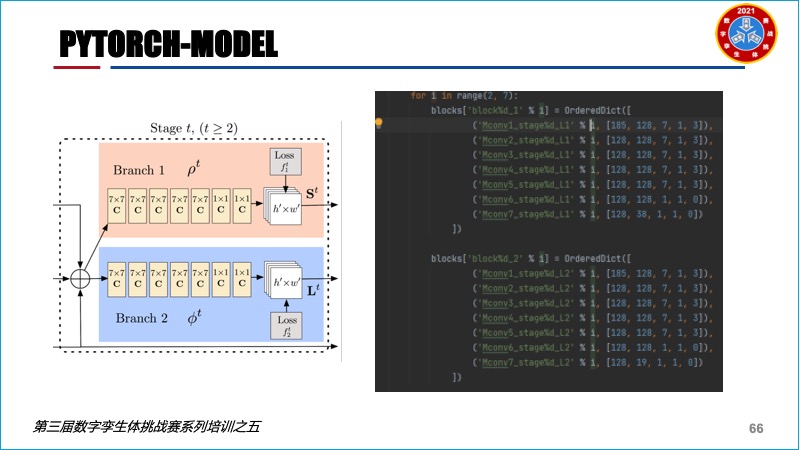

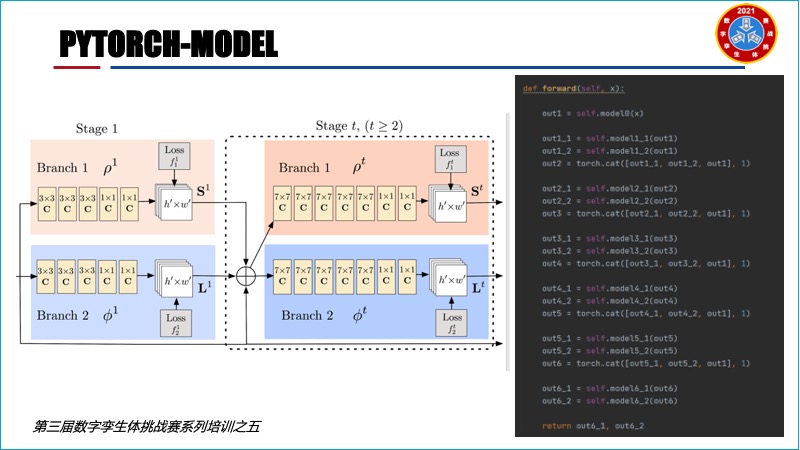

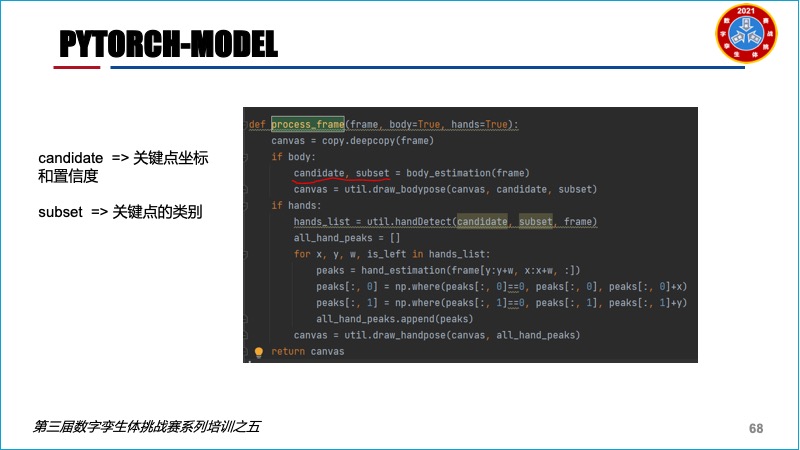

3.特征F通过一个连续的多阶段网络进行处理,网络的每个阶段(t)包含了两个分支,其输入结果分别为St (Part Confidence Map)和Lt (Part Affinity Map)。

4.其中:St告诉我们哪些地方是头部,哪些地方是胳膊肘。 Lt告诉我们哪些地方肯定在哪条大腿或者其他躯干上。

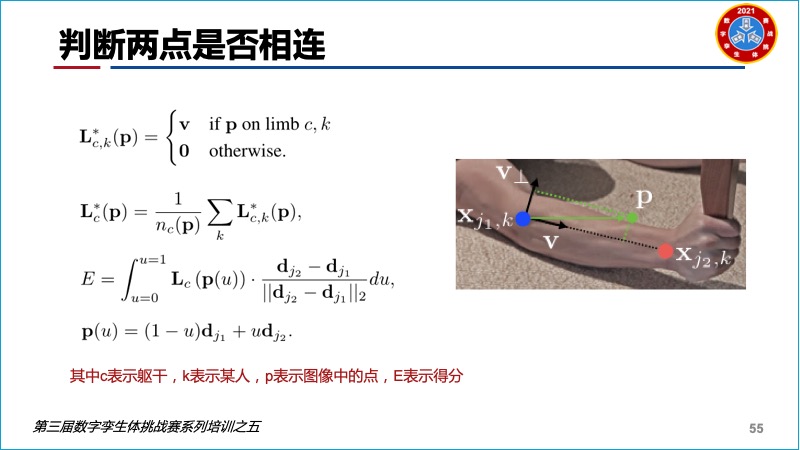

5.在Lt的帮助下,把St的坐标点连接起来,形成人的姿势骨架。

最后刘淼介绍了基于Caffe和PyTorch的OpenPose,并对后者的代码做了一定的解读,方便参赛团队更好开展开发应用。

本次培训内容比较专业,但也吸引了不少人员参与,通过该培训课程的学习,能够大大降低参赛团队自学的难度,集中精力解决国防和工业领域的应用挑战,更好实现研用结合的目标。

附:OpenPose开源项目介绍及代码解析

评论